Когда мы в детстве смотрели фантастические фильмы о будущем, то мечтали о летающих скейтбордах и колонизации Марса. А вместо этого получили новые схемы мошенничества — с использованием нейросетей и дипфейков. При помощи искусственного интеллекта стало возможно легко подделывать чужой голос и даже видеоизображение. Рассказываем на реальных примерах о набирающих популярность схемах обмана, на которые ведутся даже академики.

Дипфейк и СМС-бомбер

У Анны (имя изменено. — Прим. ред.) угнали аккаунт в Telegram. Девушка прошла по ссылке, чтобы проголосовать за знакомую по ее просьбе — ту тоже взломали. В итоге от лица Анны всем контактам стали приходить просьбы скинуть денег. После текстового сообщения шло аудио с ее голосом для большего доверия.

Послушайте, как натурально звучит фраза.

— Голос очень похож. Его прогнали через нейросеть — и готово. Чтобы люди подумали, что это реально я, — поделилась догадкой девушка.

Технология искусственного интеллекта под названием deepfake (от deep learning «глубинное обучение» + fake «подделка») активно развивается последние несколько лет. С использованием машинного обучения можно создавать убедительные подделки изображений, видео- или аудиоданных.

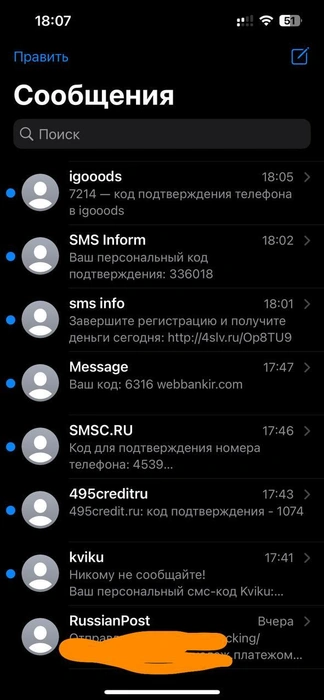

При этом, когда начались мошеннические действия, на телефон девушки обрушился спам из СМС и звонков с различных номеров. Анну атаковали так называемым СМС-бомбером, чтобы помешать вернуть аккаунт и разоблачить аферистов.

В такие моменты телефон буквально разрывается, и приходится его отключать или переводить в режим полета.

Что такое СМС-бомбер?

— Суть в том, что твой номер заносят в определенную программу, и роботы начинают подставлять его в различные формы регистрации на сайтах, чтобы в ответ тебе перезванивали разные фирмы или присылали СМС, — объясняет Сергей Голованов, главный эксперт «Лаборатории Касперского». — Это большая проблема.

По его словам, подобных роботов часто используют злоумышленники, чтобы навредить человеку из мести или скрыть преступление. Они бывают бесплатные и платные.

— Чаще всего это просто месть. Или какие-то более глубокие цели. Например, когда ждешь важный звонок — чтобы ты был недоступен. Проблема в том, что все звонки идут с реальных физических номеров. Ты ничего не сделаешь. Можно только выключить телефон или звук. Ответственность отчасти несут владельцы сервиса или сайта, которые не установили себе ни двухфакторную аутентификацию, ни капчу. Их сервис сразу же попадает в исходники бомбера, и его начинают тоже подключать к «бомбардировке». Потом, конечно, фирме приходят счета за эсэмэски, и они рано или поздно внедряют меры защиты от роботов, — пояснил Сергей Голованов.

Анна предположила, что мошенники использовали образцы ее голосовых сообщений в Telegram, чтобы скормить их нейросети и скопировать ее голос. К счастью, несмотря на все помехи, девушка смогла оперативно вернуть свой аккаунт и предупредить знакомых, что деньги просила не она. Никто не пострадал.

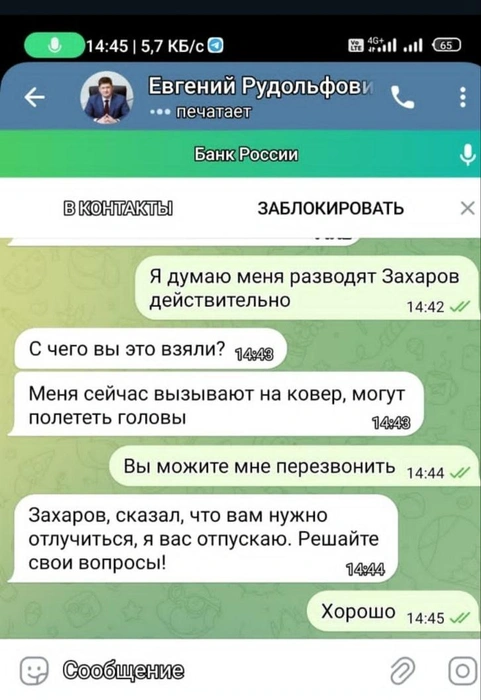

Жертвами таких атак становятся не только простые люди, но и руководители фирм и компаний, высокопоставленные госслужащие. Для них схема немного меняется.

Ложные боссы

Мэр Березовского Свердловской области Евгений Писцов недавно сообщил, что аферисты пишут и звонят людям от его имени. Как и в случае с Анной, с помощью искусственного интеллекта преступникам удалось в совершенстве сымитировать его голос.

— От моего имени мошенники вступают в переписку с вами, видимо, используя список моих контактов или данные подписчиков в соцсетях, — написал Евгений Писцов в своем Telegram-канале. — При входящем звонке вы можете не только увидеть надпись на экране с моими ФИО, но и услышать «мой» голос. Всякий разговор с мошенниками, с чего бы он ни начинался, заканчивается одним и тем же — желанием залезть к вам в карман.

— Если у вас нет номера моего телефона, значит, я не мог вам звонить. Просто прекратите общение, — призвал Евгений Писцов.

Мошенники притворялись не только главой Березовского, но и чиновниками из других регионов. Например, писали сотрудникам администрации Березовского городского округа от лица главы поселка имени Свердлова Ленинградской области.

В этом случае мошенники также использовали нейросети и голосовые дипфейки для того, чтобы вызвать эмоции доверия, тревоги, «прогреть» жертву и в дальнейшем не просто просить деньги на карту, а развести по уже классической схеме: «Проходит секретная операция, надо перевести деньги на безопасный счет».

По словам экспертов, «ложные боссы» — это очередная производная телефонного мошенничества, которая оказалась очень эффективной и малозатратной для злоумышленников.

— Это сейчас популярные тренды — звонки в мессенджере, создание легенды. Использование копии голоса. Даже у нас в компании время от времени ложный Евгений Касперский пишет сотрудникам, что сейчас им поступит звонок. Полностью схема выглядит так: сначала звонит известный номер и сбрасывает. Пишет, что связь плохая и, мол, сейчас запишу голосовое. Приходит аудиосообщение с очень похожим голосом. Единственное — у него интонация роботизированная. Всё это для того, чтобы максимально войти в доверие, — поясняет Сергей Голованов.

По его словам, фальшивые аккаунты нередко создаются после массового слива данных:

— Эти данные часто есть в интернете. Можно посмотреть адрес организации, кто заказывал доставку по этому адресу. Пойти в социальные сети и взять фото руководителя. Мошенники знают номер человека и номер его начальника. Голос можно взять из интервью в интернете. И начинается: «Здравствуйте, сейчас с вами свяжется кто-то из правоохранителей или регуляторов, сделайте, как они скажут». К сожалению, эта схема оказалась очень эффективной. Классическое телефонное мошенничество с предварительным «прогревом».

Как распознать подделку

— Насторожить должны искусственность, роботизированность и монотонность голоса. Похожим может быть пока только короткое сообщение. На длинном это всё бросается в глаза, — Владислав Тушканов, руководитель группы исследований и разработки технологий машинного обучения в «Лаборатории Касперского». — Мы пробовали самые разные технологии копирования голоса. Пока что полностью скопировать голос человека не удается. Потому что он включает в себя тембр, интонации, какие слова использует, как паузы расставляет и так далее. Для хорошей подделки требуется большой массив данных. И чем длиннее сообщение, тем больше можно заметить нестыковок.

По словам Владислава Тушканова, в 2024 году уже нельзя полностью доверять всему, что видишь и слышишь.

— Надо критически подходить к контенту, — говорит он. — Сейчас есть удачные дипфейки с видео, когда накладывают на человека лицо другого персонажа. Правда, для этого пока приходится подбирать похожего актера. А когда было землетрясение в Турции, мошенники разместили твит со сбором денег на криптокошелек и, чтобы вызвать эмоции, использовали сгенерированное изображение, на котором пожарный спасал ребенка из-под завалов. Выглядело очень реалистично, но у пожарного было шесть пальцев (типичная ошибка ранних нейросетей. — Прим. ред.).

Изначально технология копирования голоса имела и полезное применение. Например, когда известный актер из-за рака внезапно потерял голос, то снятый с его участием фильм удалось озвучить с помощью нейросети, обученной на образцах. Однако в последнее время эта технология всё чаще упоминается в контексте мошеннических действий.

Пока единственный гарантированный способ разоблачить подделку — перезвонить самому. А еще лучше — сделать видеозвонок.

— Когда тебе приходит подозрительное или нехарактерное сообщение от человека, то надо перепроверить, — подчеркнул эксперт «Лаборатории Касперского». — Лучше связаться и уточнить, отправлял ли он его. Перезвонить или видеозвонок сделать. Пока эти технологии еще развиваются, разоблачить подделку довольно просто. Но сейчас все уже ждут появления прямого эфира (подделки изображения в реальном времени. — Прим. ред.). И это уже будет опасно.

«Когда менять голос смогут в режиме онлайн, у всех нас будут огромные проблемы»

Ранее мы рассказывали, как мошенники крадут аккаунты «Госуслуг» и для чего они им нужны.

Прочитайте также, какие десять фраз выдают мошенников. Услышав их, нужно положить трубку или прекратить переписку.